Esther | 编辑

为了训练属于AR眼镜的视觉助手、提升AR定位能力,Meta早在2020年就开始通过Project Aria项目收集第一人称视频数据,用来训练AR眼镜的计算视觉算法。Meta表示:现有的计算机视觉算法主要是根据第三人称视角的照片和视频训练而成,因此总是以旁观者角度去感知周围环境。如果要让机器人、AR眼镜像人一样感知世界,那么将需要使用第一人称数据来训练,也就是人在执行各类任务时眼前看到的画面。

历经两年时间,Meta在新加坡、英国、美国等地陆续收集了大量第一人称视频数据。项目共有3000人参与数据收集,包括Meta员工、承包商、有偿的外部参与者等等,项目合作方包括卡内基梅隆大学、新加坡国立大学、宝马等等。数据采集环境包括Meta办公室、获得批准的私人住宅、公共场所。

最近,Meta将在美国拍摄的数据面向AI、ML科研人员开放,以加速机器感知和AI技术发展。Meta表示:发布Aria Pilot数据集的目的是,向外部科研人员展示一种可重复的研究基准,目的是推动第一人称计算机视觉、场景感知AI/ML算法的发展。

Aria Pilot数据集

据青亭网了解,这个数据集名为Project Aria Pilot,其中包含了159段第一人称视频,累计时长7小时,分别拍摄于每个5个地点。视频中包含了各种日常生活场景,比如洗碗、开门、做饭、在客厅使用手机、玩游戏、锻炼等等。除此之外,还包括利用多视角动捕系统拍摄的桌面交互数据,其中包含了人与物体交互的视频。此外,Aria Pilot数据集中还包含多个由演员拍摄的全天候视频,记录了Aria眼镜全天传感/捕捉环境数据的效果。

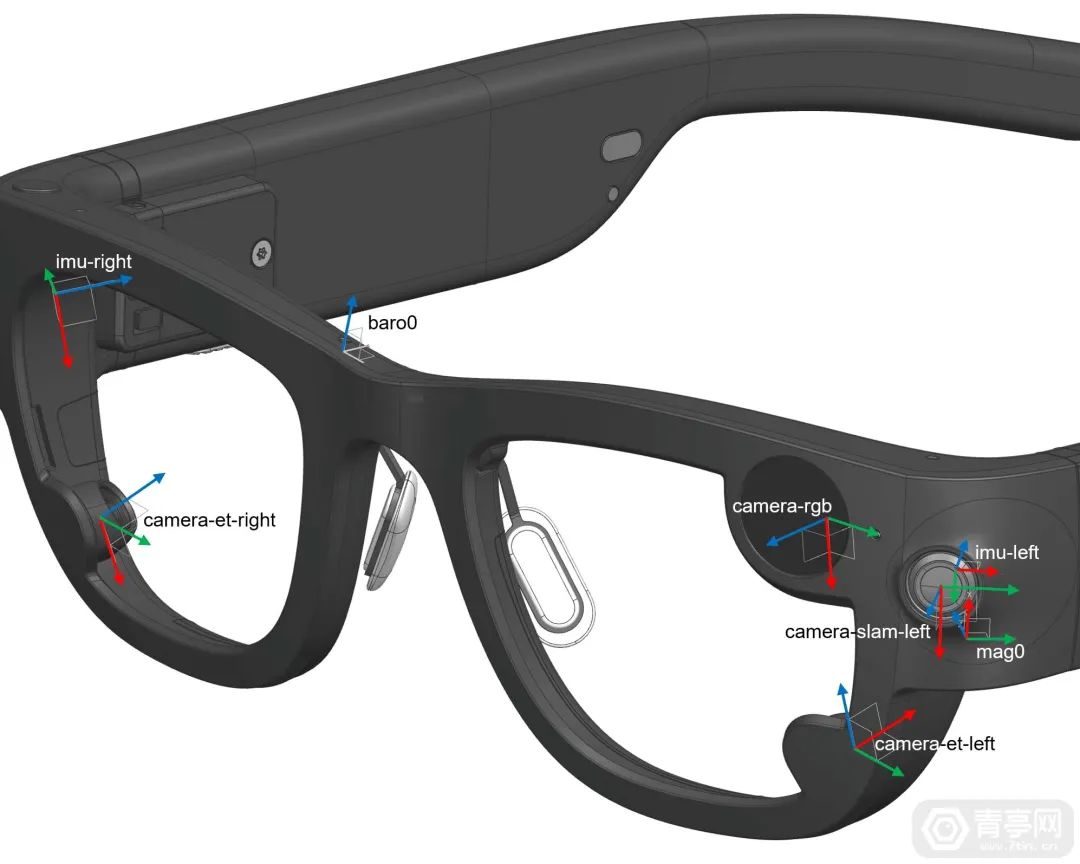

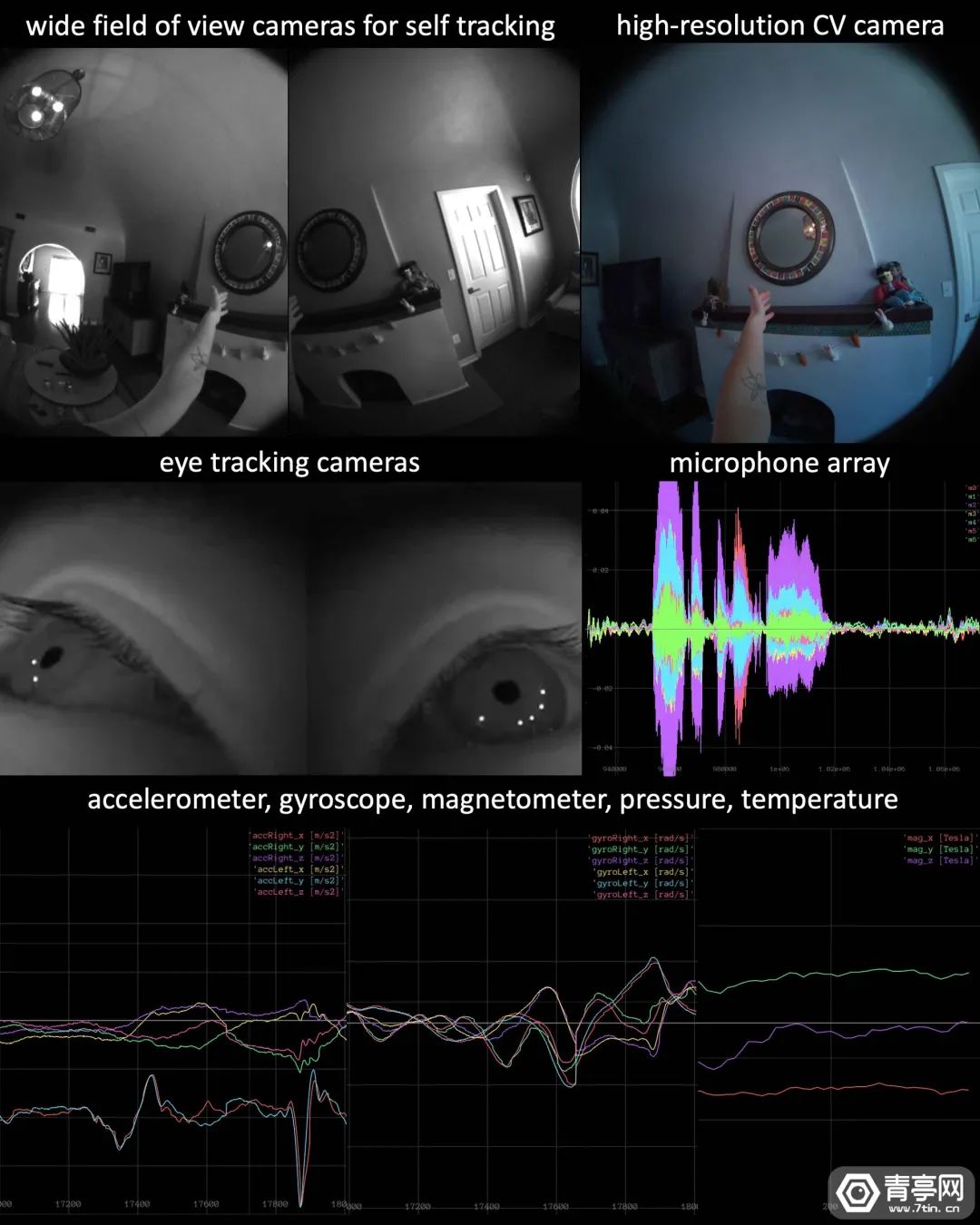

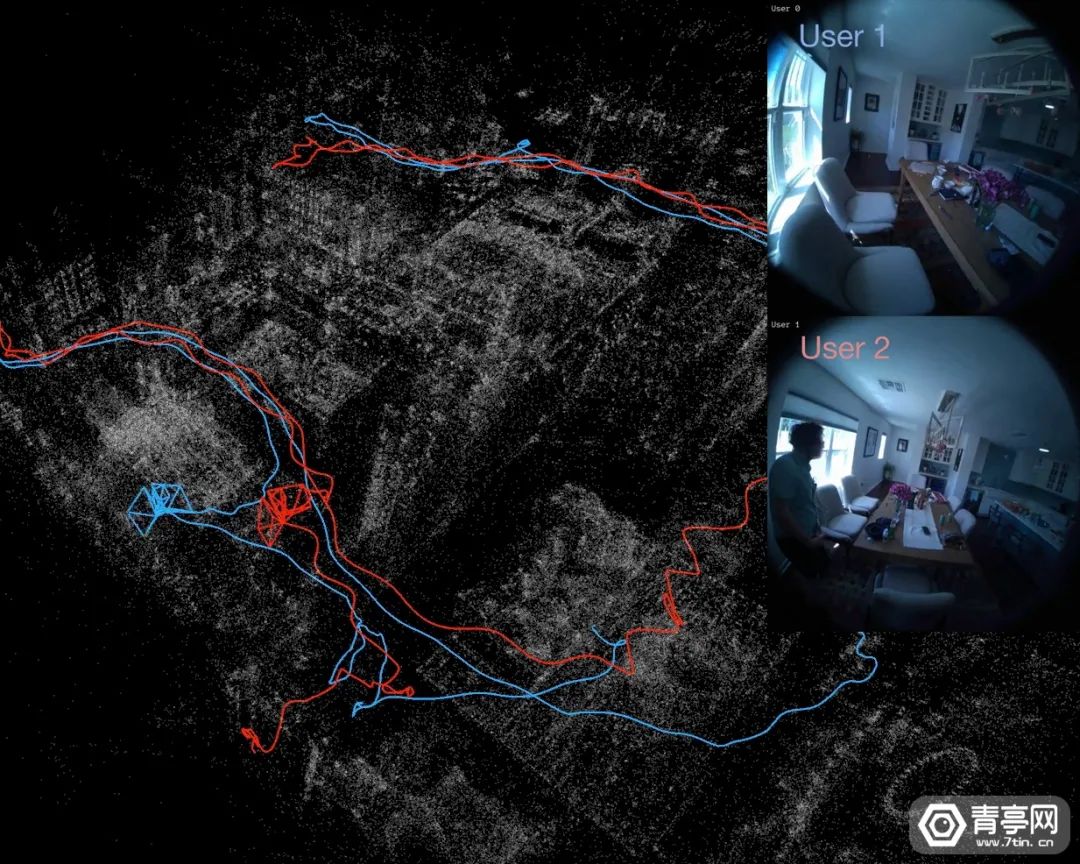

实际上,Meta此前也曾推出过开源第一人称视频数据集Ego4D,区别是Ego4D采用头戴摄像头拍摄,设备不限于GoPro,以及Vuzix Blade等AR/拍照眼镜。相比之下,Project Aria Pilot真正基于Meta研发的眼镜设备拍摄,其拍摄角度、高度将更好的满足训练Meta AR眼镜助手的需求。值得注意的是,Aria Pilot是一个匿名的视频数据集,为了隐私安全将人脸、车牌等关键信息进行了模糊处理。Meta在原始视频基础上,不仅去掉了隐私信息,还加入了自动和手动标记/注释,帮助机器学习/AI模型理解场景的失控参考框架和上下文信息。为了帮助AI理解同一个参考框架中多个用户的姿态/运动,Aria Pilot数据集还将同一场景中捕捉的数据与这个参考帧对齐,目的是允许算法共享该场景的上下文信息。同时,Project Aria Pilot数据集还将视频数据的时间线对齐,也就是说不同的设备可共享同一时间捕捉的视频数据,这将有望推动多人共享AR效果。Meta还公开了Aria眼镜所配备的传感器,不同的传感器负责收集不同的数据,其中包括:- 两个150°FOV全局快门单摄(用于SLAM和手势追踪);

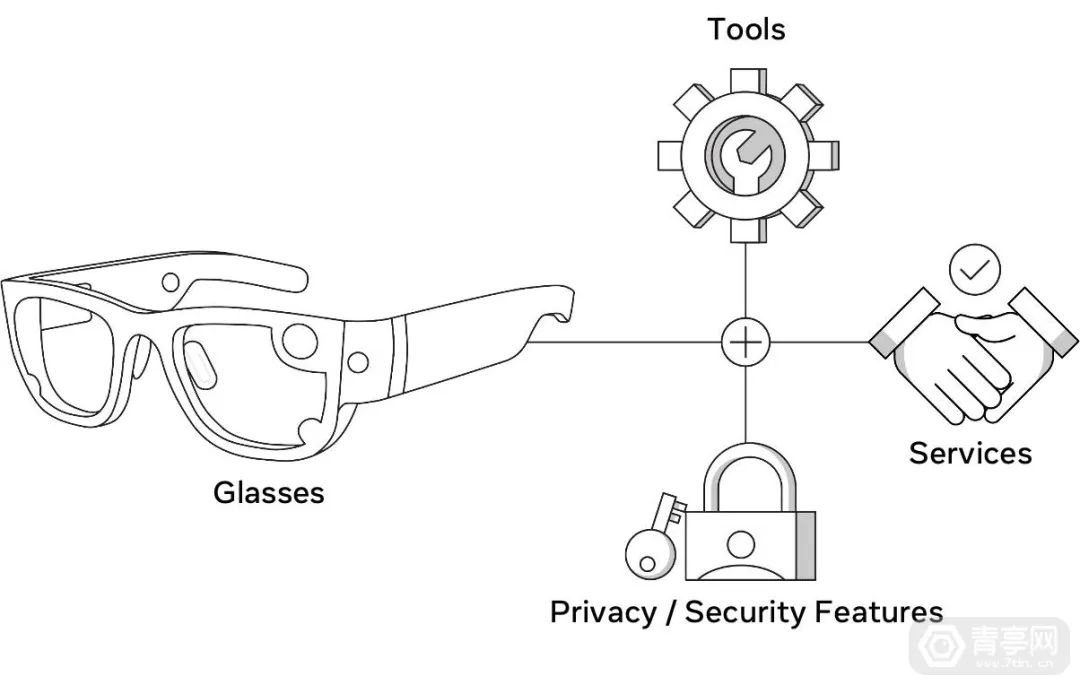

- 两个80°FOV全局快门单摄(配备IR光源,用于眼球追踪);

- 两个1KHz IMU+气压计+磁力计+环境传感器;

此外还配备眼球追踪模块,主要用于校正佩戴者的注视点,也可以加速人与物体交互的研究。除了图像外,Project Aria也收集语音数据,因此Meta在Aria Pilot数据集中也加入了语音转文本注释。这样的数据可以训练算法来预测对话轮换,以及多人对话转写。应用场景方面,Aria Pilot数据集可应用于多种研究领域,包括相机重定位、场景重建等机器感知和AI技术,而这些研究将成为改善AR设备的关键。细节方面,Project Aria通过收集第一人称视频数据,可帮助Meta构建实时3D空间地图等软件,也有助于推动AR眼镜的硬件迭代。此外,也可以帮助开发者、科研人员探索AR在真实世界的潜在用途。Meta表示:Project Aria的目标是,通过AR眼镜等产品,将计算设备融入日常生活中,不干扰人的日常互动、任务执行、运动等等。同时,进一步增强周围的物理世界,使得人机交互设计和体验更加人性化。同时,第一人称视频数据也有望用来构建实时3D地图,以帮助视觉助手定位物品,执行快速找钥匙等任务。Meta表示:未来的AR设备需要更具感知力,才能发挥真正的价值。而为了让AR设备了解她与人、周围物体之间的关系,分析当下的情境,将需要基于物理环境的3D地图。据了解,Magic Leap、HoloLens等AR设备通过实时3D空间扫描来动态更新场景结构/布局,但这种方式不仅耗电,还难以规模化。如果开发一个大规模的3D地图,将有助于加速AR眼镜理解周围环境的速度。Meta开发的实时3D地图(LiveMaps)使用计算机视觉来识别环境并进行定位显示。利用LiveMaps功能,AR眼镜将可以有效查看、分析、了解周围世界,为用户更好的服务。此外,LiveMaps将实时更新,帮助AR眼镜追踪街道变化等信息。Project Aria的目的之一,就是测试LiveMaps的实际应用效果。Meta指出,AR设备和体验将加深人与环境、事物之间的联系,并提供更多实用功能和信息,减少低头看手机的时间。Meta计划构建一个以人为本的AR生态系统,设计出透明、有意义、考虑周到、人性化的技术。https://about.facebook.com/realitylabs/projectaria/datasets( END)

关注公众号:拾黑(shiheibook)了解更多

赞助链接:

关注数据与安全,洞悉企业级服务市场:https://www.ijiandao.com/

四季很好,只要有你,文娱排行榜:https://www.yaopaiming.com/

让资讯触达的更精准有趣:https://www.0xu.cn/

*文章为作者独立观点,不代表 K2数据恢复大师 立场

本文由

青亭网发表,转载此文章须经作者同意,并请附上出处(

K2数据恢复大师 )及本页链接。

原文链接 https

://www.51uos.com/news/industry/4295.html