负责任的AI,你的安全感微软守护

(本文阅读时间:9分钟)

毫无疑问,我们的世界已经迅速地与数字技术交融。小到一次刷码出行、一次订单支付、你在云端敲下的一个字符,都在数字世界构建了一个欣欣向荣的孪生体。但面对看不见的数据“黑盒子”,我们的安全感从何而来?

数据安全是数字技术的基石,但它的完善不是一蹴而就的,领先的云服务商等关键角色有责任将其作为价值观去时时进益。其中,人工智能(AI)等热门技术近年来在日常生活中的广泛应用开始引发大众对于隐私的担忧。因此,我们向大家介绍微软负责任的 AI 标准,这是一个指导构建 AI 系统的框架,来让我们以身作则,在开发更好、更可信的技术和产品中守住价值观底线。

一直以来,微软采用六项基本原则来更广泛地指导 AI 工作,在此基础之上我们针对例如人脸识别技术等独特的风险进行了进一步的更新。6 月底微软宣布停止销售基于人脸图像猜测情绪的技术,并且不再提供不受限制访问的人脸识别技术。我们发现,对“情绪”的定义缺乏共识等种种原因,可能会使人们遭受刻板印象、歧视或者不公平的拒绝服务。

技术是为了更好地服务生活而非创造障碍。在最新版负责任的 AI 标准中,我们希望与业界共同探讨知识和经验,从 AI 开始,共同推动建立更好、更透明的数据隐私安全规范和实践。

▲ 微软负责任的 AI

1

引导开发,

让 AI 更负责任

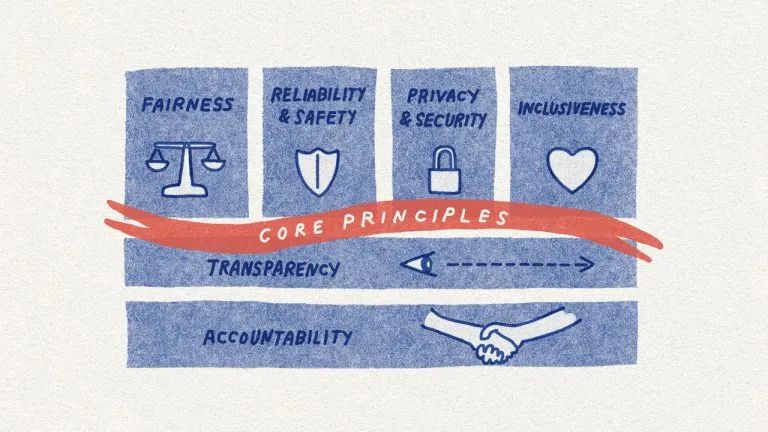

AI 实际是人们在开发、部署过程中所作的众多决策的产物,因此从目的设定到互动方式,在开发的各个环节我们都应该对需要做的各种决策进行积极引导,以确保最终结果更有益且更公平。AI 系统在一开始确定设计时,就需要以人和目标为中心,与此同时,微软还制定了其应该坚守的六大原则——公平、可靠和安全、隐私与保障、包容、透明、负责。

负责任 AI 标准反映了微软对于如何构建能够体现这些原则并赢得社会信任的 AI 系统的思考。这一标准为我们团队提供了具有针对性和可行性的指导意见,确保我们走在 AI 治理的最前沿。

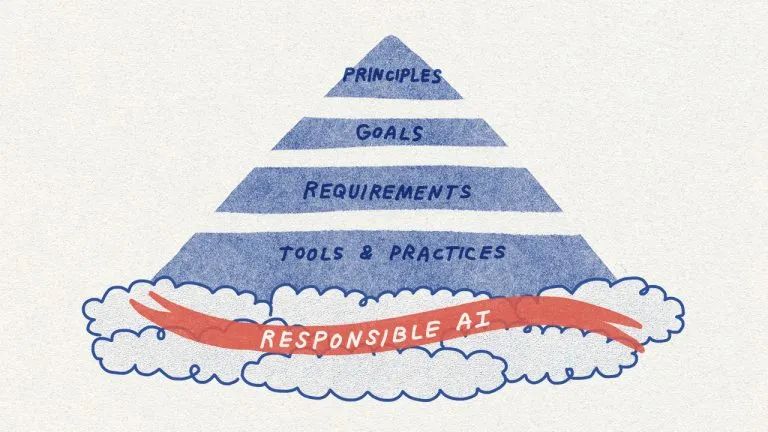

标准对 AI 团队必须努力达成的各个具体目标或成果进行了详细说明。这些目标将“负责”原则拆解为影响评估、数据管控、人工监督等多个关键促成因素;每个目标还包含一系列要求,这些要求是团队必须采取的步骤,以确保整个系统生命周期内 AI 都不偏离目标;标准还将可用的工具和实践与特定要求相匹配,以便团队在执行时有现成的资源可用。

▲ 微软负责任 AI 标准的核心构成:

原则、目标、要求、工具与实践

业界很需要类似的实用型指南。如上文所述,日常生活中 AI 应用越来越常见,但政策法规还未健全。虽然相关机构正在加大 AI 领域的治理,但我们应该肩负起责任并采取行动,确保 AI 系统在设计之初就“负责任”。

2

持续完善,

基于产品不断学习

负责任 AI 标准的第一版于2019年秋季在微软内部推出,这次推出的改进版由过去一年来我们抽调的研究人员、工程师、政策专家组成的多学科小组精心编制而成,涵盖了微软在负责任 AI 领域所作的努力、最新研究成果,以及从产品中获得的重要经验等。

语音转文字技术中的公平性问题

AI 系统可能会加剧社会偏见和不平等现象,这是业界公认的由 AI 系统带来的坏处之一。2020 年3月,一项学术研究显示,在整个技术领域内,对于一些黑人和非裔美国人群体而言,语音转文字技术的出错率几乎是白人群体的两倍。我们回顾并思考了这项研究结果,了解到我们在预发布测试中并未全面考虑来自不同地区、拥有不同背景的人群丰富多样的语言。在这项研究发表后,我们聘请了一位社会语言专家来帮助我们更好地理解语言多样性,并试图扩大我们的数据收集工作,以缩小语音转文字技术的性能差异。在这个过程中,我们发现我们需要努力解决一些极具挑战性的问题——即如何以一种得体且尊重对方的方式从各群体中收集数据。我们还意识到让专家尽早参与到技术开发流程中的重要性,包括帮助我们更好地了解可能导致系统性能差异的因素。

负责任 AI 标准记录了我们改善语音转文字技术所遵循的模式。随着我们继续在全公司推广该标准,我们希望其中明确的公平性目标和要求将有助于我们提前应对有损公平性的潜在问题。

自定义神经语音和人脸识别的合理使用监管

Azure AI 的自定义神经语音是另一项创新型微软语音技术,可用于创建听起来几乎与原始音源相同的合成语音。AT&T 公司在屡获殊荣的 Bugs Bunny 店内将这一技术付诸实践,Progressive 公司在线上与客户进行互动时使用 Flo 语音。此外,许多其他客户也在使用这项技术。这项技术在教育、无障碍服务、娱乐领域都具有较大潜力,但也很容易被用来模仿声音对他人进行欺骗。

我们通过负责任的 AI 计划对这项技术进行了审核,包括落实敏感用途审核流程,这促使我们采用分层控制框架:限制客户对服务的访问,确保通过透明度说明(Transparency Note)和行为准则(Code of Conduct)对可接受的用例主动进行定义和说明,并建立了技术围栏,以帮助确保在创建合成语音时语音提供者能够积极参与其中。通过上述和其他治理措施,防止技术被滥用,同时确保技术能够发挥有益的作用。

基于我们在自定义神经语音技术领域积累的知识和经验,我们将在自身的人脸识别服务中应用类似管控措施。在现有客户度过过渡期之后,我们仅会将这些服务的访问权限授予托管客户和合作伙伴,将用例范围缩小到预定义的可接受用例,并合理利用服务中设计的技术管控措施。

符合目标(Fit for Purpose)与 Azure 人脸识别功能

最后,我们意识到,要让 AI 可信赖,它们应该是符合目标的解决方案。在确保 Azure 人脸识别服务符合负责任 AI 标准相关要求的过程中,我们弃用了推断情绪状态和身份属性(包括性别、年龄、微笑、胡须、头发和妆容等)的功能。

以情绪状态为例,我们已决定不支持通过开放式 API 访问权限扫描人脸并根据面部表情或动作来推断情绪状态的人脸识别技术。公司内外的专家强调对“情绪”的定义缺乏科学共识,相关挑战包括:如何跨越不同用例、地区和人群实现准确推断,以及人们越来越关注这类功能的隐私问题。我们还决定,我们需要仔细分析所有声称能够推断人们情绪状态的 AI 系统,无论这些系统是使用面部分析还是任何其他 AI 技术。当前,负责任 AI 标准中的“符合目标(Fit for Purpose)”目标与要求可帮助我们提前对特定系统进行有效性评估,我们与敏感用途相关的流程有助于我们基于科学为影响较大的用例提供细致入微的指导。

这些现实出现的挑战促进了微软负责任 AI 标准的发展,也切实影响了我们设计、开发和部署 AI 的方式。

对于有意深入研究的人员,我们也提供了支撑负责任 AI 标准的重要资源,包括我们的影响评估模板和指南,以及一系列透明度说明。微软已经验证了影响评估的重要性,即影响评估可以确保团队在最早期设计阶段深入探索 AI 系统可能会带来的影响,包括其利益相关者、预期益处和潜在危害等。透明度说明采用全新文档形式,我们在其中向客户披露了我们的核心构建模块技术的功能和限制因素,从而为他们提供制定负责任部署决策所需的知识。

▲ 微软负责任 AI 标准以核心原则为基础

3

融会贯通多学科,

不断更新迭代

我们最新版负责任 AI 标准中采纳了微软不同技术、专业领域和地理位置的数百条意见。这是我们建立负责任 AI 实践的重要一步,因为它更具可操作性和相关性:这套标准给出了提前识别、衡量和减轻系统危害的实用方法,并要求团队采取管控措施,从而防止技术被滥用,以及确保技术能够发挥有益的作用。

虽然制定标准是微软负责任 AI 之旅的重要一步,但这只是其中一步。我们预计在实施过程中会遇到各种挑战,可能需要我们暂停下来不断反思和调整。我们的标准将作为一份动态文件,不断加以完善以纳入公司内外的新研究、新技术、新法规以及新的知识与经验。

在全球范围内,关于如何创建具有原则性和可操作性的规范以确保组织以负责任的方式开发和部署 AI 的讨论层出不穷。我们从这些讨论中受益匪浅,也将继续为这些讨论提供我们的见解。我们认为,产业界、学术界、社会和政府应该携手推动前沿技术的发展,并相互学习。我们需要共同解决开放性研究问题,弥合度异,并创建全新的实践、模式、资源和工具。

创建更美好、更公平的未来需要新的 AI 技术“护城墙”。微软通过制定负责任 AI 标准助力实现这一目标,并在整个公司层面开展势在必行的实践工作。我们致力于在开展相关工作过程中保持公开、诚实和透明,以期取得富有意义的进展。

关注公众号:拾黑(shiheibook)了解更多

赞助链接:

关注数据与安全,洞悉企业级服务市场:https://www.ijiandao.com/

四季很好,只要有你,文娱排行榜:https://www.yaopaiming.com/

让资讯触达的更精准有趣:https://www.0xu.cn/

关注网络尖刀微信公众号

关注网络尖刀微信公众号随时掌握互联网精彩

- 微软云计算曝出惊天漏洞:可接管全球任何企业租户

- Fort Firewall 开源免费、功能强大的 Windows 系统防火墙软件

- 港币对人民币汇率2024年7月28日

- 2023健康险失速,他们道出了行业发展另一面

- 科学视野中的人工智能:挑战、机遇与未来

- 卢布汇率人民币2023年8月19日

- 加元兑换人民币汇率2023年8月9日

- 彻底拥抱eSIM,还需要做什么

- CloudDrive – 将 115、阿里云盘 挂载为本地电脑硬盘

- 苹果将大幅削减iPhone 12 mini产量,骁龙895已经进入测试阶段

- 轻薄和性能不可兼得? OPPO Reno5 Pro游戏测试

- 同方云管理平台与统一操作系统UOS完成兼容性互认证

微信扫码关注公众号

微信扫码关注公众号